Microsoft 2023 Build: 用于浏览器推理的 ONNX Runtime Web 框架及 WebNN 整合

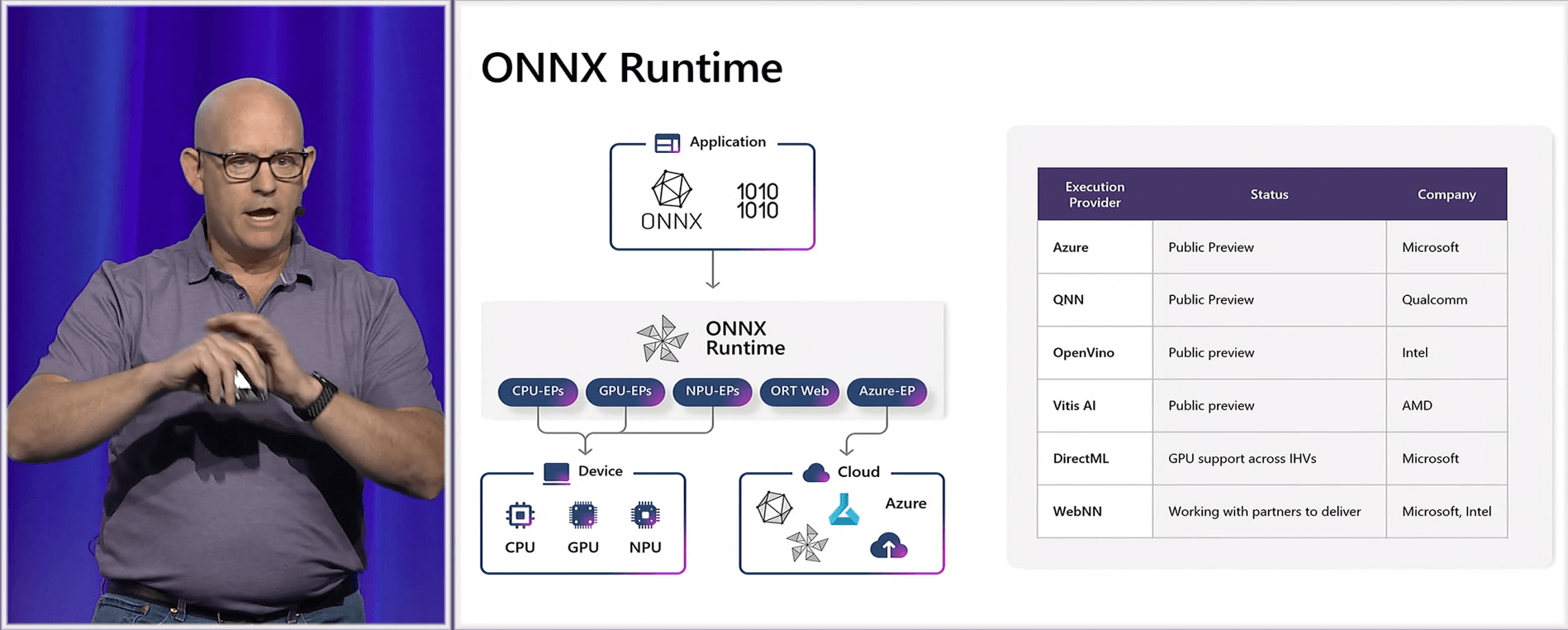

在 Microsoft 2023 Build 大会上,Panos Panay 宣布 ONNX Runtime 作为 Windows AI 的 Gateway。 ONNX Runtime 可以跨 CPU、GPU、NPU 或与 Azure 混合在任何 Windows 或其他设备上运行 AI 模型。 微软还推出了 Olive 工具链,旨在减轻开发人员为各种 Windows 和其他设备优化模型的负担。 ONNX Runtime 和 Olive 都有助于加快将 AI 模型部署到应用中的速度。

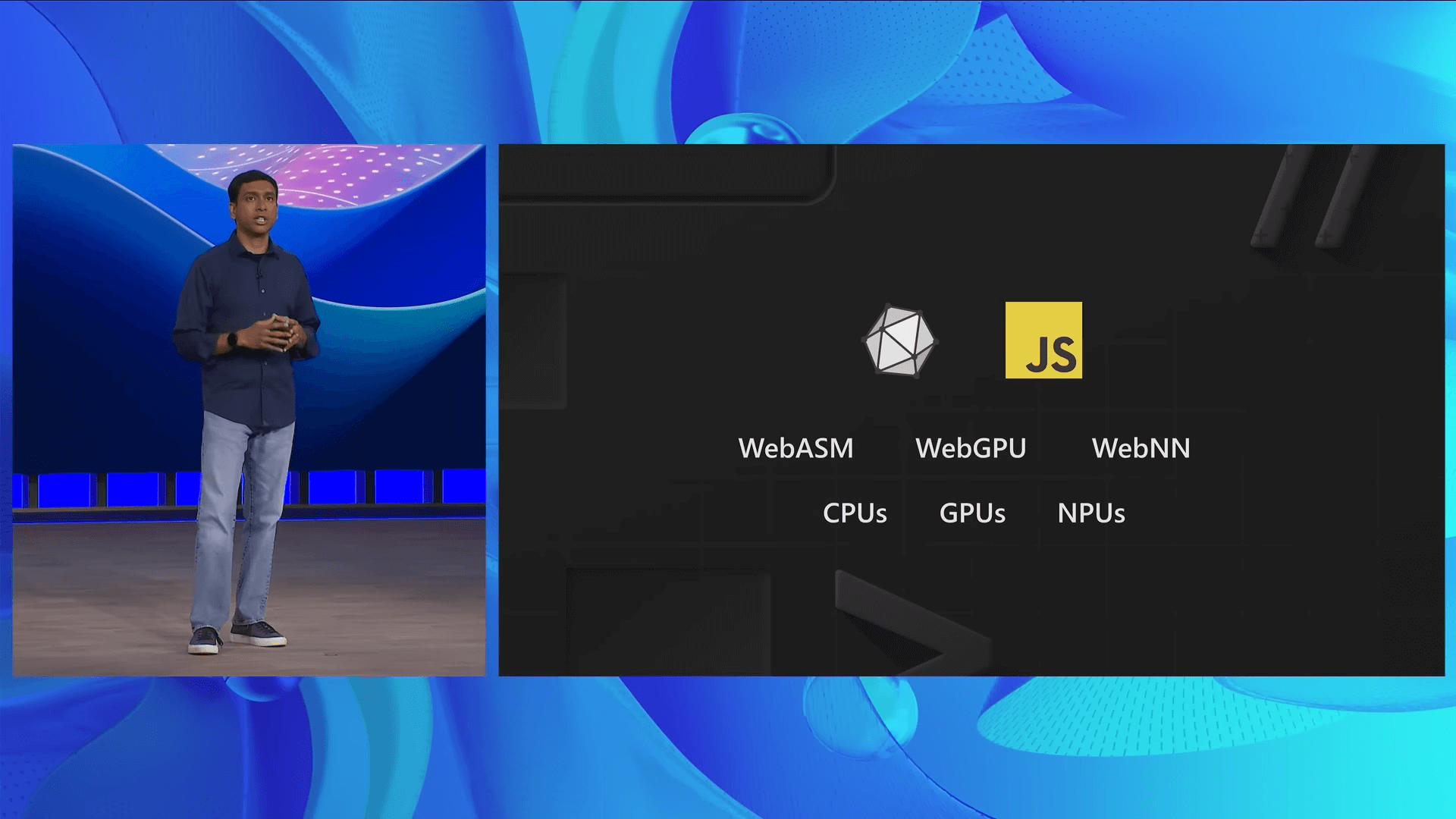

在多个演讲中,微软提到还支持使用 ONNX Runtime Web 在浏览器中进行推理,并正在与伙伴英特尔合作整合 WebNN。

微软 Principal PM Jeff Mendenhall 提到:

We’re also working on a WebNN so that you can continue with Web ORT that exists today. It can do local inferencing in-browser. We’re also implementing the WebNN standard, and we’re working with Intel so once all of code changes get approved, it’s coming soon at this point.

我们还在开发 WebNN,以便您可以继续使用目前存在的 ONNX Runtime Web。 它可以在浏览器中进行本地推理。 我们也在实施 WebNN 标准,我们正在与英特尔合作,因此一旦所有代码更改获得批准,它很快就会出现。

微软 CVP Pavan Davuluri 在 Microsoft Build 2023 第二天的演讲中提到, 除了 CPU, GPU 之外, 专有的 NPU AI 硬件加速器正在不断地进入到 Windows 生态,多家厂商均进行了支持,而支持 NPU 的 WebNN API 也将很快到来。